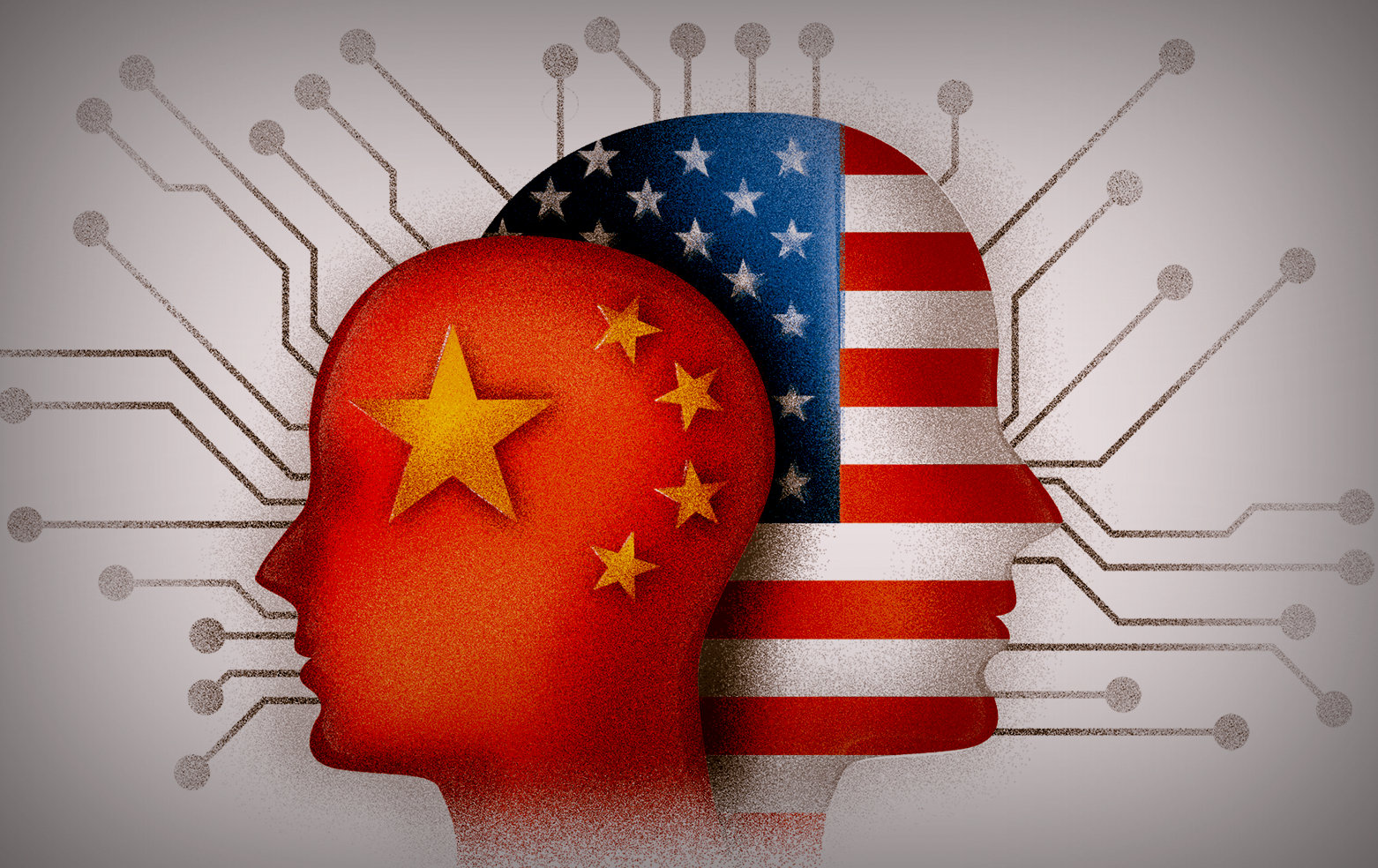

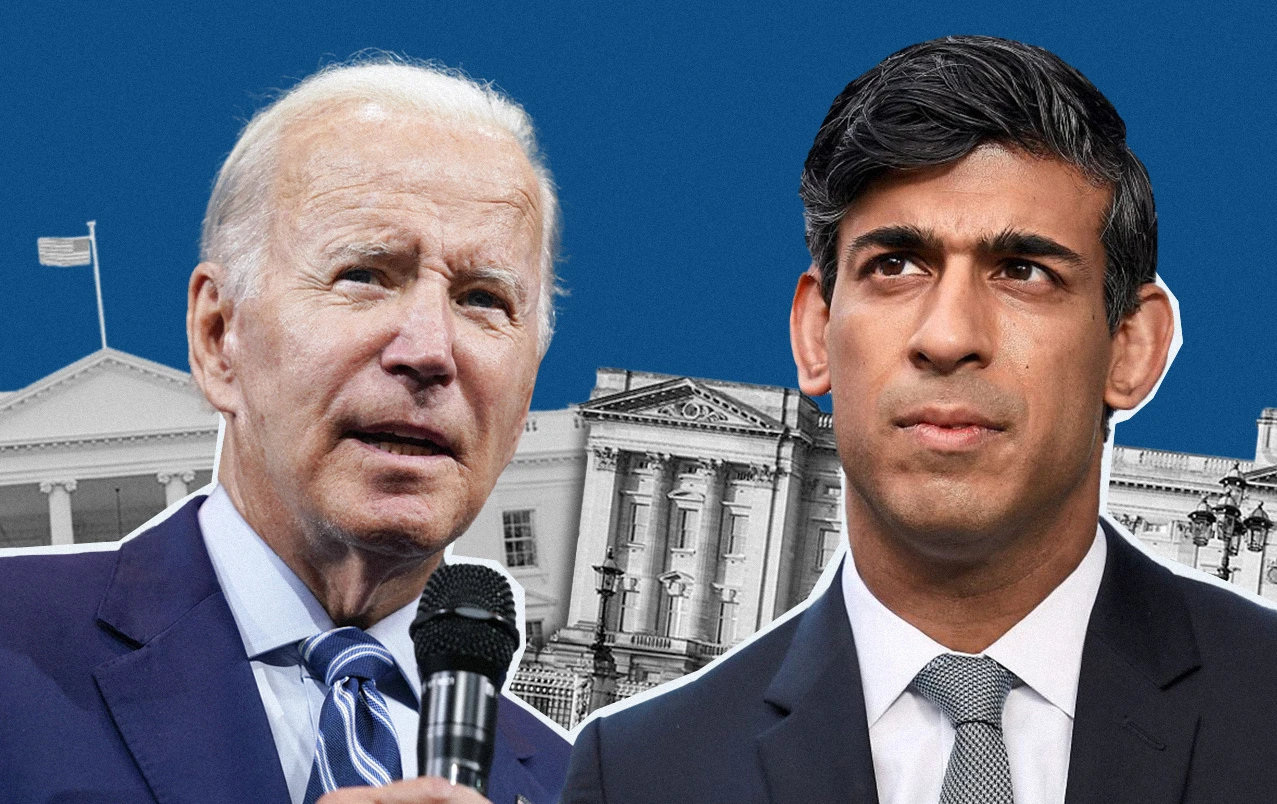

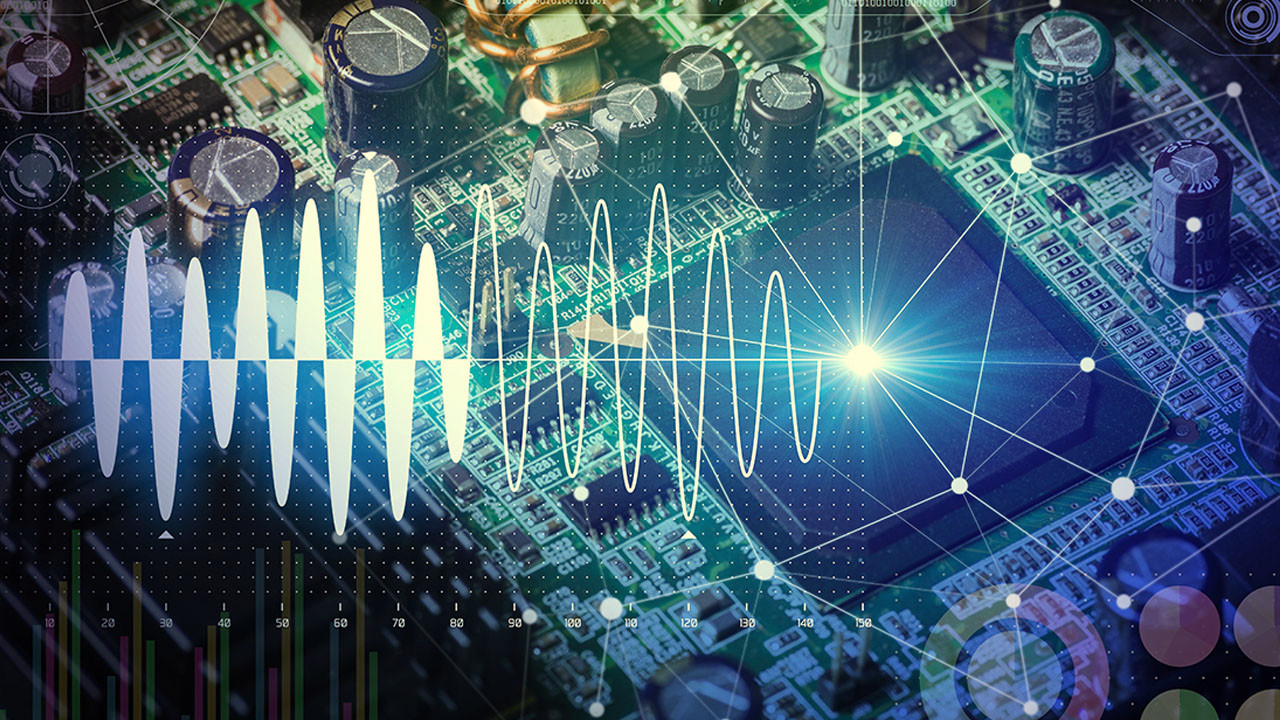

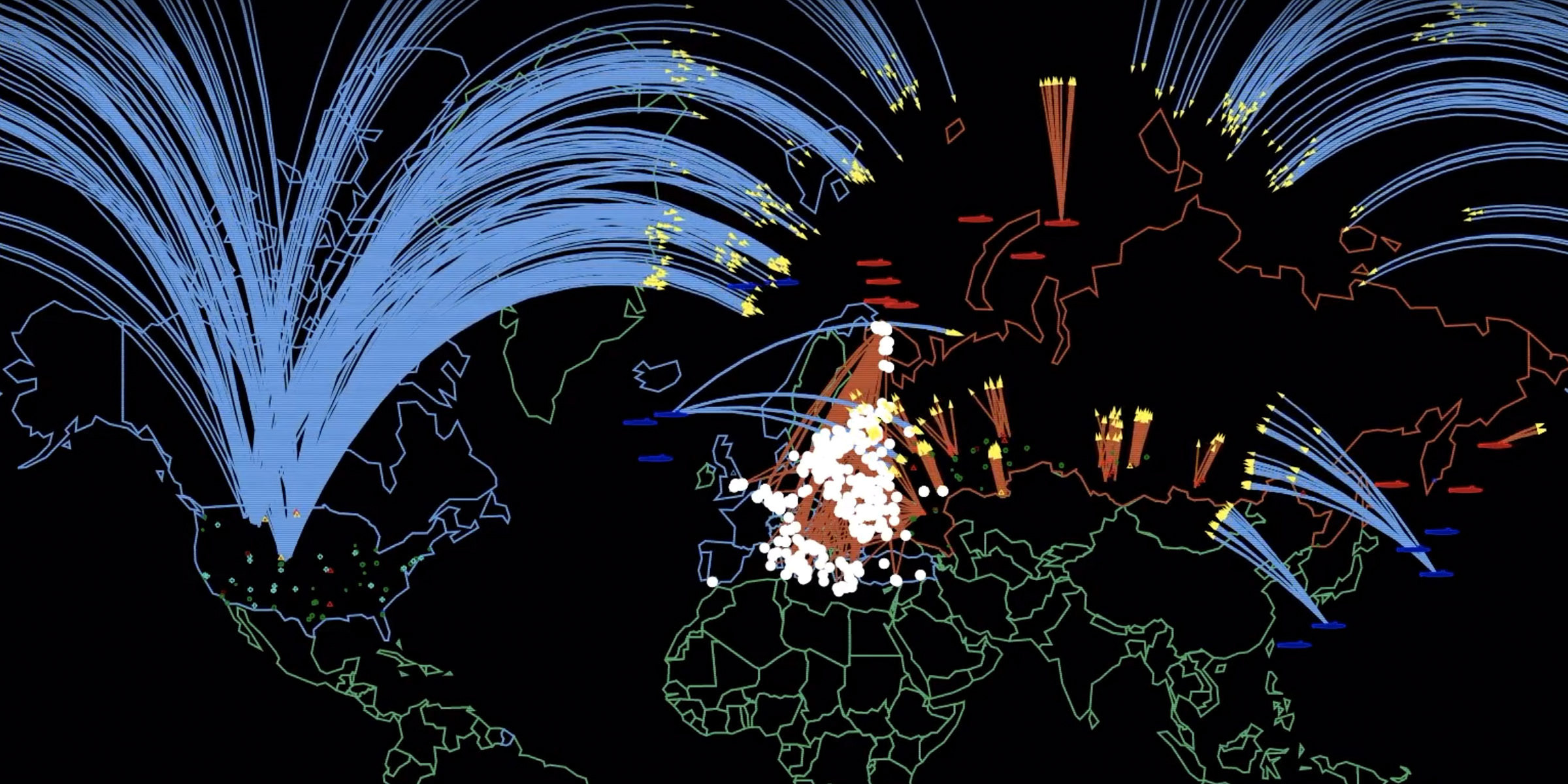

Il lato oscuro della «civiltà delle macchine», ciò che emerge da una notizia che spiega (in parte) l’origine dei massacri di Gaza. John Kirby, portavoce del Consiglio per la Sicurezza nazionale Usa, parlando dell’enorme numero di vittime civili nella Striscia, ha annunciato un’indagine Usa, sul possibile utilizzo di «sistemi di intelligenza artificiale da parte di Israele, durante i suoi bombardamenti».

Intelligenza artificiale e stupidità umana

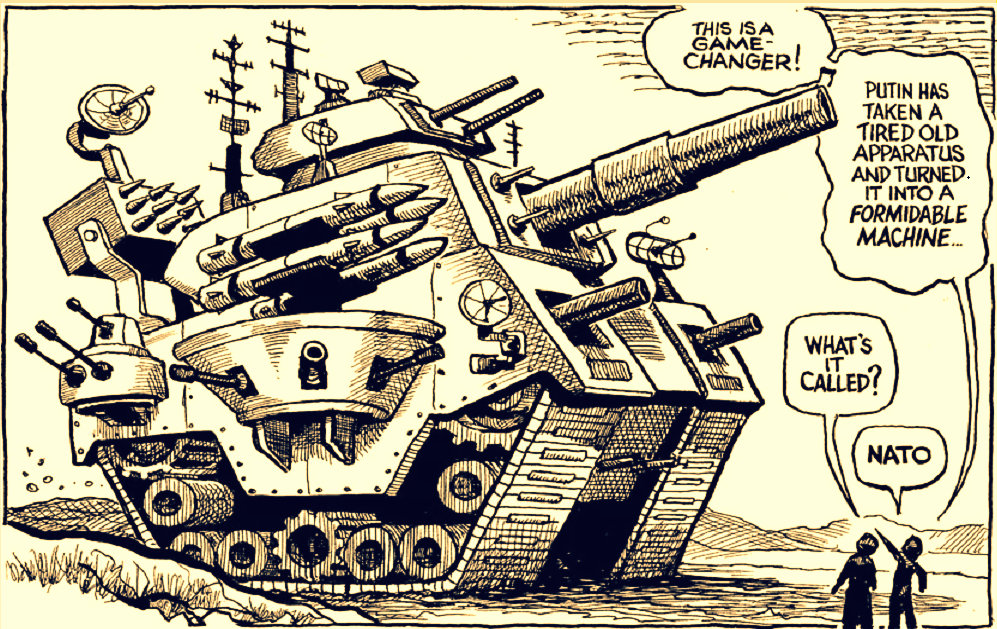

Un modello d’intervento che, se fosse confermato, riuscirebbe a spiegare anche l’apparente sproporzione, tra danni inflitti (enormi) e risultati raggiunti (modesti) dagli attacchi dell’IDF. Intorno a quest’ennesimo capitolo di una crisi sempre più imprevedibile, alcuni media israeliani specializzati (+972 Magazine e Local Call) hanno tirato fuori un dettagliatissimo rapporto. Che hanno poi messo a disposizione della stampa internazionale, inviandolo anche alla Casa Bianca. Lo Stato Maggiore dell’IDF, subito dopo la diffusione del documento, ha negato decisamente che forze armate israeliane usino modelli di intelligenza artificiale per selezionare i bersagli umani.

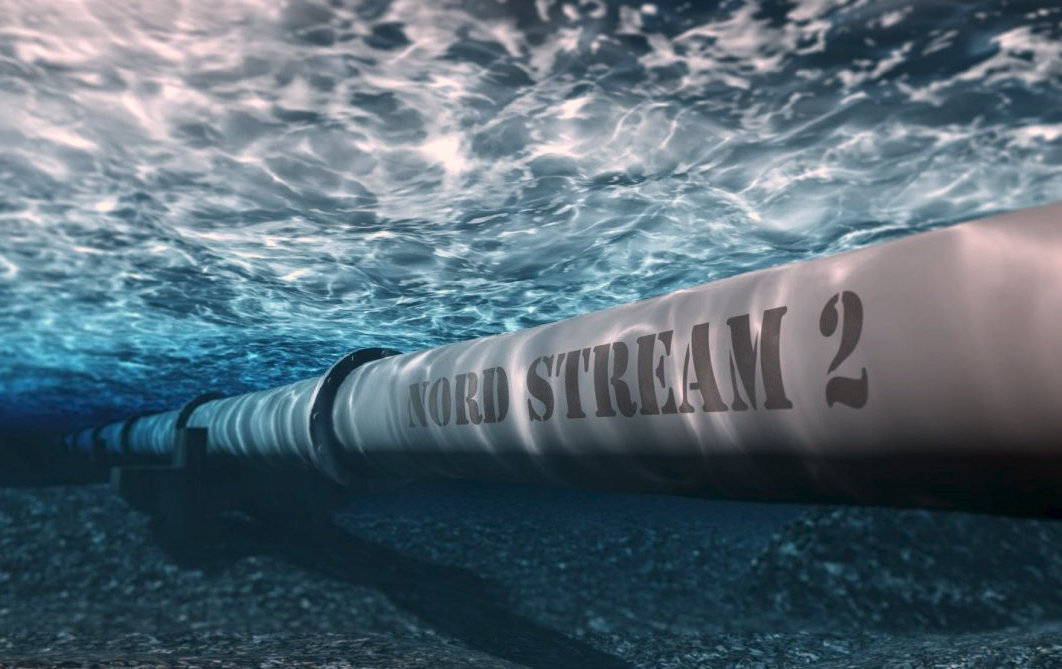

La micidiale ‘Lavanda’

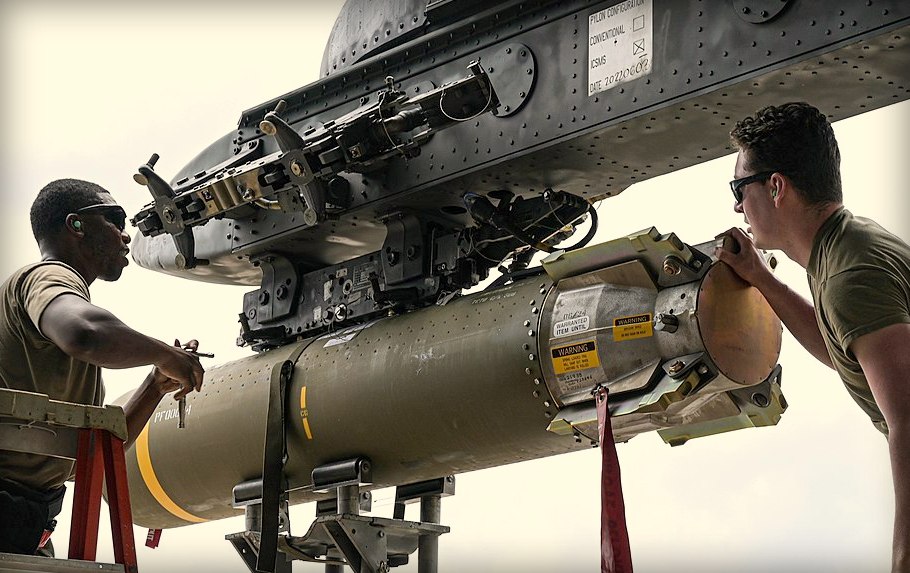

Ma +972 racconta un’altra verità. «Lavanda – scrive il magazine – è la macchina di Intelligenza Artificiale che dirige i bombardamenti israeliani a Gaza». E il mortale progetto che mette assieme microchip di ultima generazione, bombe a guida laser e missili sofisticati così viene sintetizzato: «L’esercito di Tel Aviv ha contrassegnato decine di migliaia di abitanti di Gaza come sospettati di omicidio. Lo ha fatto utilizzando un sistema di targeting basato sull’IA, con scarsa supervisione umana». Questa è solo la parte introduttiva del modello. Perché il giornalista Yuval Abraham, che presenta il report, aggiunge considerazioni terrificanti: «Secondo sei ufficiali dell’Intelligence, che hanno tutti prestato servizio a Gaza e sono stati coinvolti in prima persona nell’uso dell’intelligenza artificiale, per generare obiettivi da assassinare».

«Lavanda ha avuto un ruolo centrale nel bombardamento senza precedenti dei palestinesi. Soprattutto durante le prime fasi della guerra. Si trattavano i risultati della macchina come se fossero le decisioni di una mente umana».

Ancora peggio, 37 mila bersagli

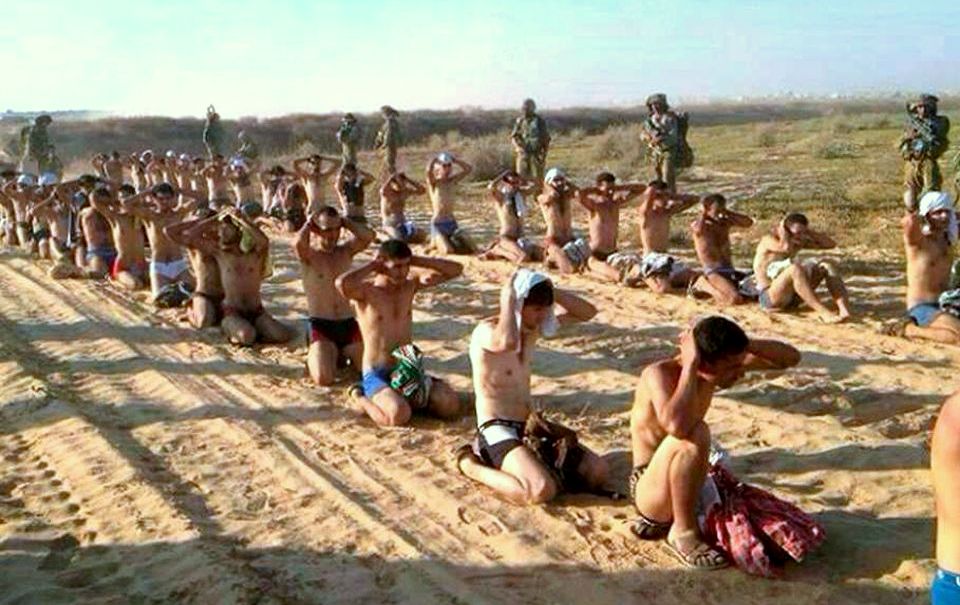

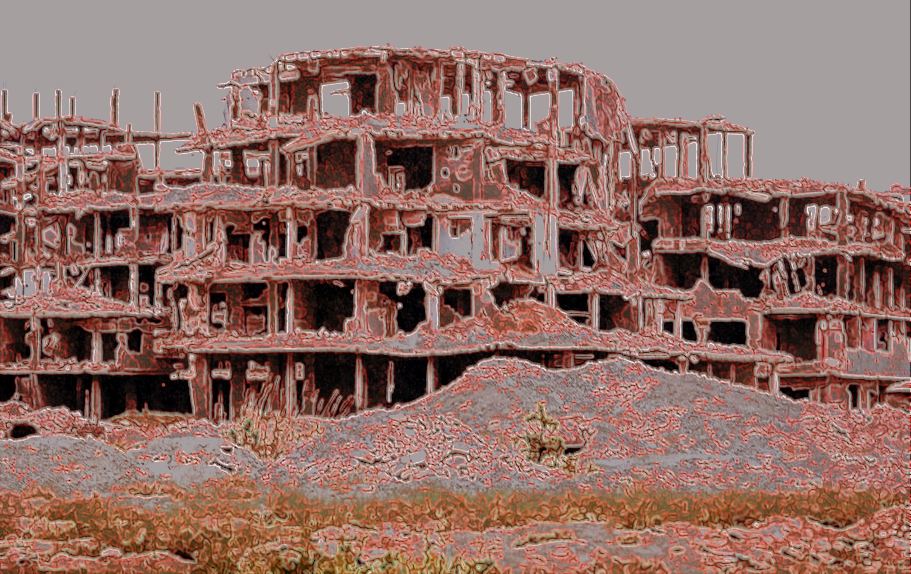

Ma il problema, chiarisce Abraham, sta ancora più a monte. È il ‘software’ cervellotico, il programma caricato con criteri statistici molto approssimativi, che si è liquefatto sotto una realtà fin troppo complessa per degli scatoloni di ferraglia riempiti di microchip. Che non potranno mai sostituire un cervello fatto di razionalità, ma anche di emozioni. Invece, a Gaza, i programmi ‘geniali’ di Tel Aviv, all’inizio della guerra, «hanno individuato fino a 37 mila palestinesi come sospetti militanti e le loro case come possibili bersagli di attacchi aerei». Naturalmente, gli esponenti di grosso calibro di Hamas erano qualche decina. Il resto era costituito da ‘manovalanza’ o, addirittura, dalla palude dei ‘fiancheggiatori‘. Che vuol dire tutto e niente.

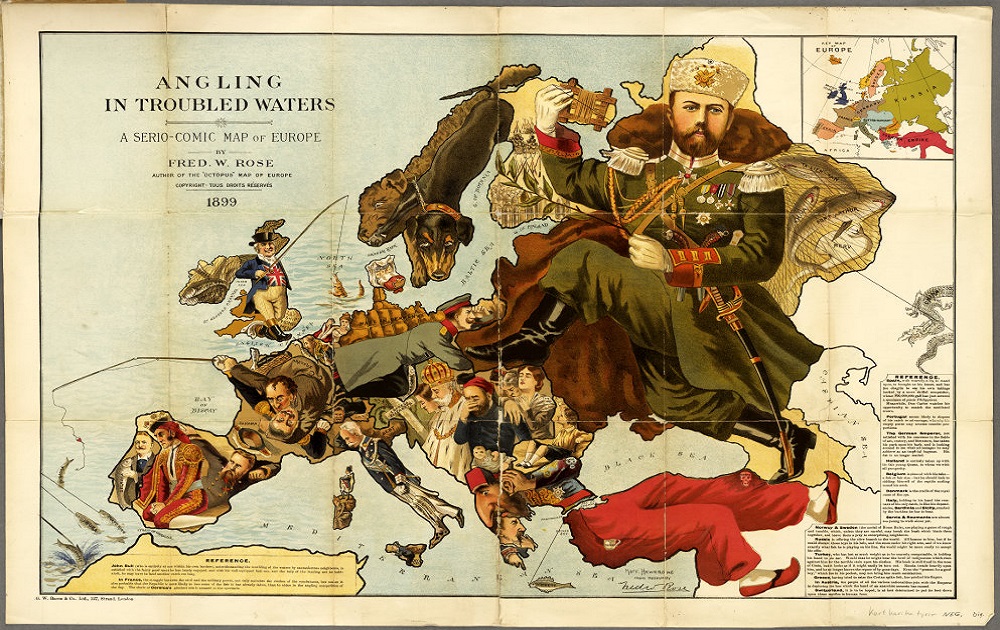

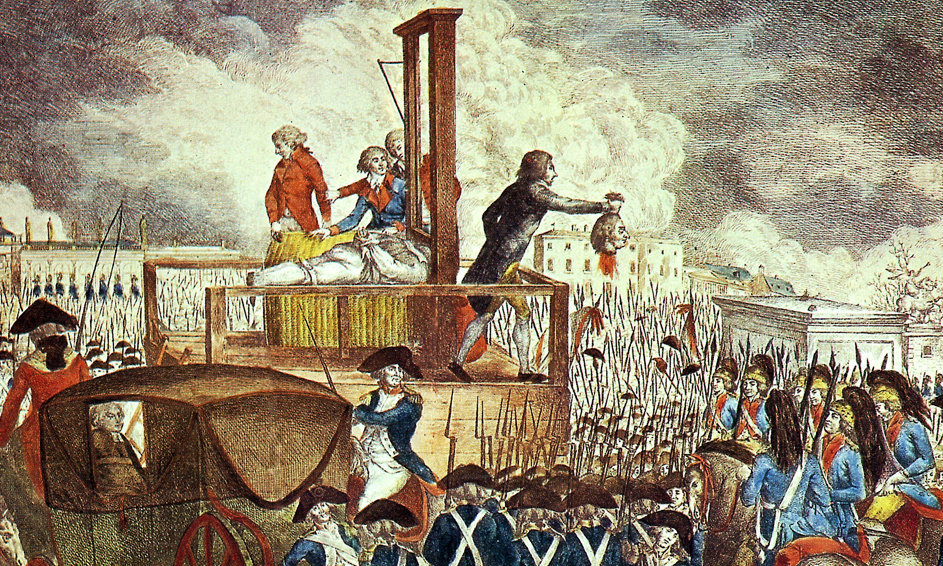

Sparare nel mucchio

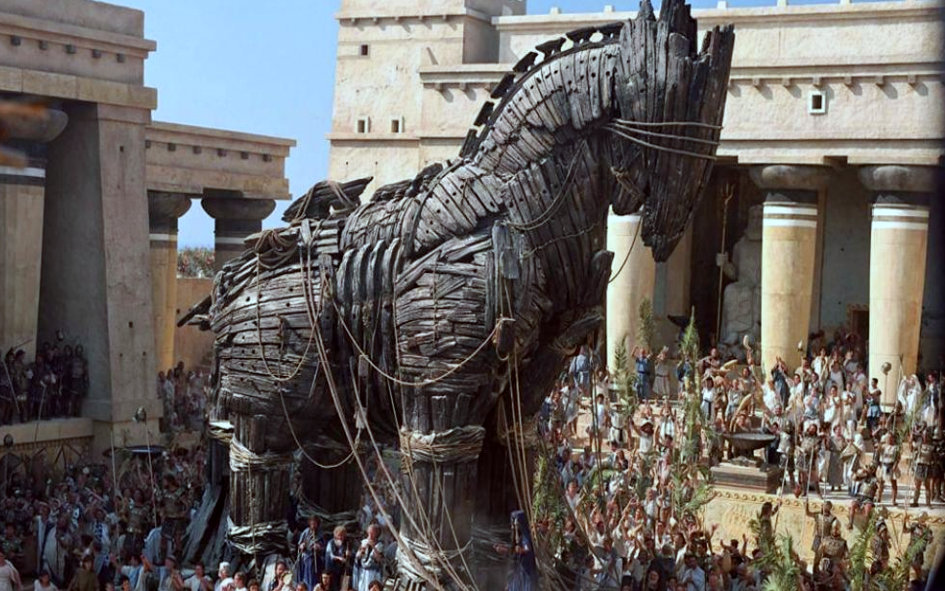

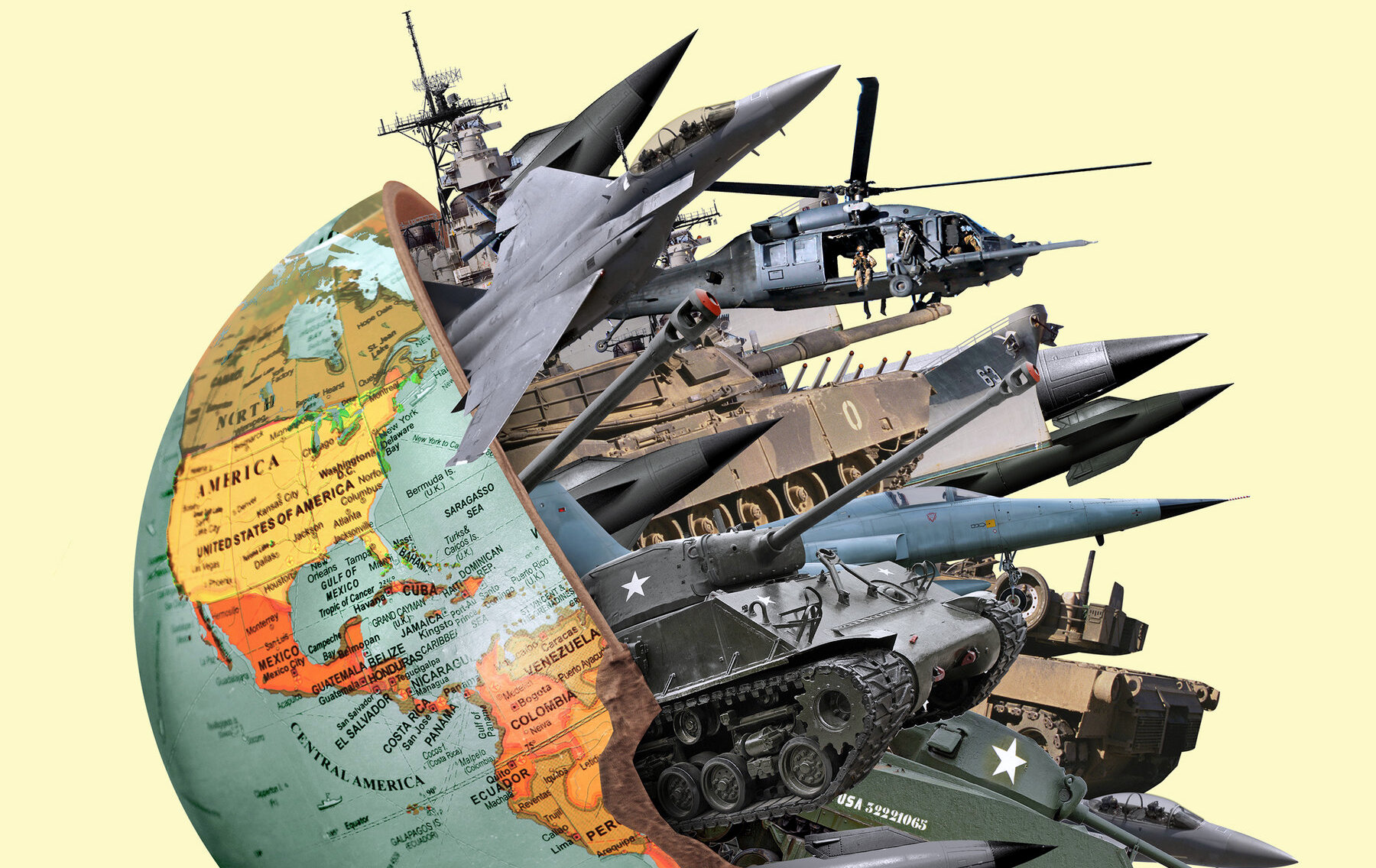

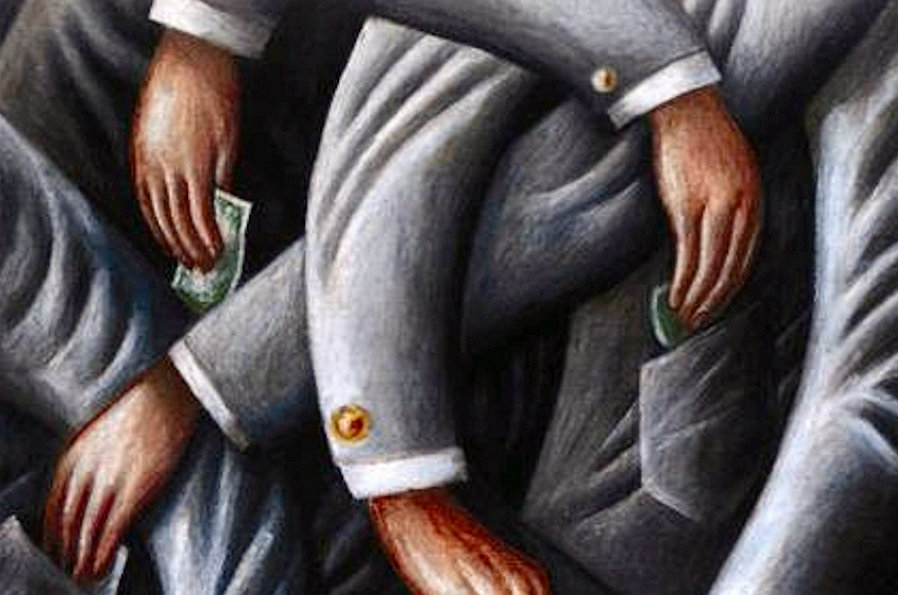

Insomma, la carneficina di Gaza potrebbe nascere proprio dalla foia di voler eliminare i ‘pesci grossi’ di Hamas sparando nel mucchio. Anche. Ma resta, secondo gli autori dell’inchiesta, la netta sensazione di un programma che di «intelligente ha ben poco, perché l’eliminazione dell’avversario è fatta all’ingrosso». Il 10% dei bersagli ‘ufficiali’ selezionati già non c’entra niente in partenza. Inoltre, quelli inseriti nella lista per «sospetto terrorismo», sono spesso accompagnati da accuse inconsistenti. Il sistema Lavanda si accoppia con un altro programma di intelligenza artificiale, noto come «The Gospel» (il Vangelo). Che però, non ha niente di sacro, ma viene utilizzato per classificare edifici e infrastrutture da distruggere. Lavanda, invece, è la sentenza di morte per le persone.

Oltre a Lavanda, anche ‘The Gospel’

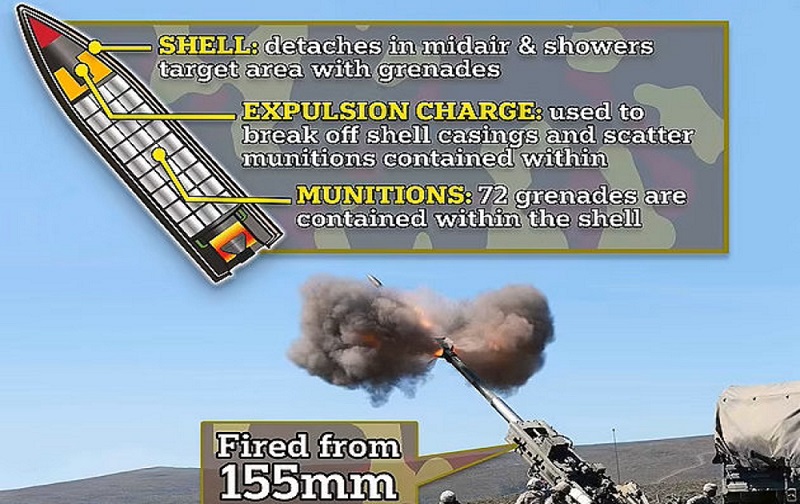

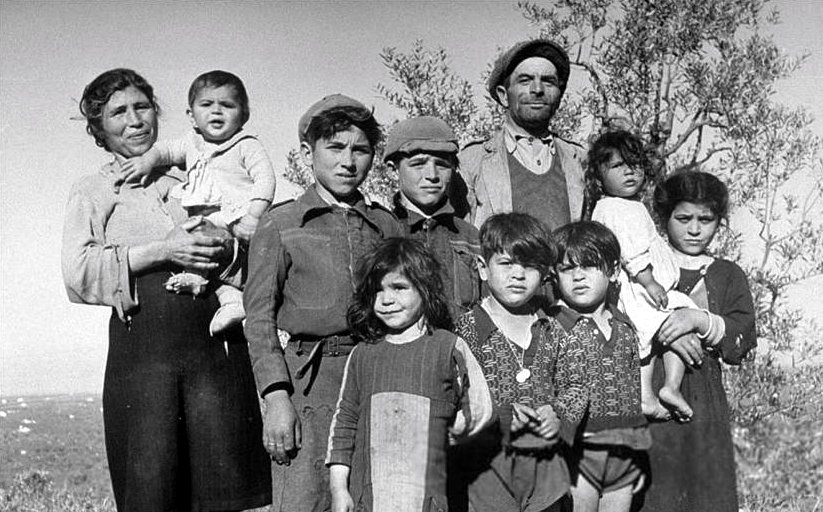

Si muore a migliaia, c’è scritto nel rapporto, perché la quasi totalità dei palestinesi segnalati nella lista Lavanda non costituisce un vero pericolo. Quindi, per loro si usano ‘bombe stupide’, che costano poco, piovono a casaccio, ma ammazzano un sacco di gente. «Inoltre – conclude Abraham – l’esercito israeliano ha attaccato sistematicamente le persone prese di mira, mentre si trovavano nelle loro case. Di solito, di notte, quando erano con le loro famiglie, piuttosto che nel corso di un’attività militare. Ciò era dovuto al fatto che era più facile localizzare le persone nelle loro case.

Ulteriori sistemi automatizzati, incluso uno chiamato ‘Dov’è papà?’, venivano usati per rintracciare i bersagli quando rientravano in famiglia». Ora si capisce meglio, come nasce la strage dei bambini e delle mamme di Gaza.

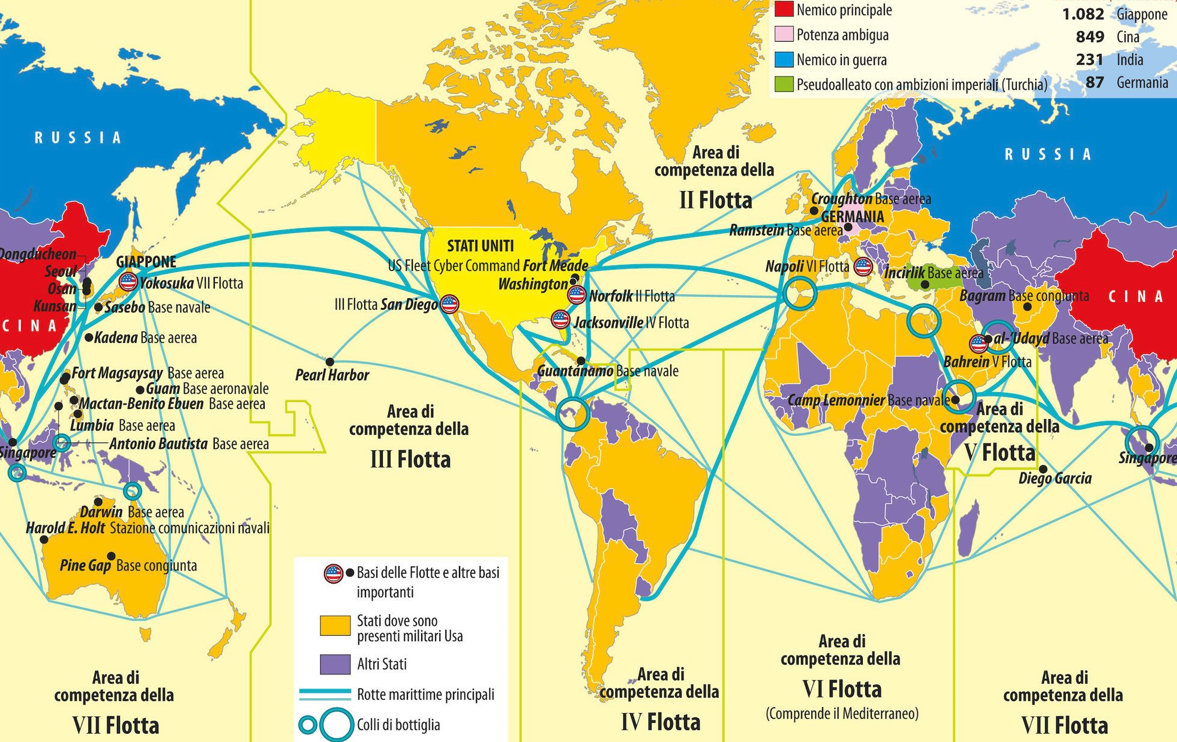

Unità 8200

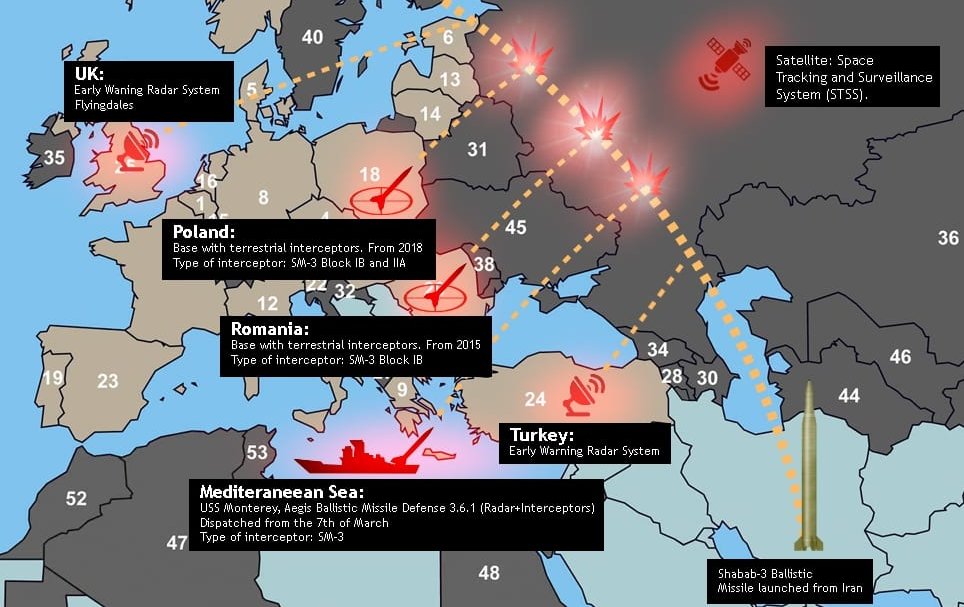

Nel 2021 è stato pubblicato in inglese un libro intitolato The Human-Machine Team: How to Create Synergy Between Human and Artificial Intelligence That Will Revolutionize Our World, sotto lo pseudonimo «Brigadier General Y.S.». In esso, l’autore – un uomo che abbiamo confermato essere l’attuale comandante dell’unità di intelligence d’elite israeliana 8200 – sostiene la necessità di creare una macchina speciale, in grado di processare rapidamente enormi quantità di dati per generare migliaia di potenziali «obiettivi» per gli attacchi militari nel mezzo di una guerra. Una tecnologia del genere, scrive, risolverebbe quelle che ha descritto come «strettoie umane, sia nell’individuazione di nuovi obiettivi che nel processo decisionale per approvarli».

Una nuova inchiesta condotta da +972 Magazine e Local Call rivela che l’esercito israeliano ha sviluppato un programma basato sull’intelligenza artificiale noto come Lavender, di cui si scrive per la prima volta.